Profesori prava na Univerzitetu u Bostonu, Woodrow Hartzog i Jessica Silbey, svojim nacrtom rada "Kako vještačka inteligencija razara institucije", mnoge će propisno da razljute. Najglasniji kritičari, međutim, neće biti zastupnici korišćenja vještačke inteligencije. Mislim da će dio akademske zajednice prezreti samo shvatanje „institucije“ kao „hijerarhije autoriteta“ koju vrijedi očuvati, na šta će se nasloniti neobični saveznici — libertarijanci vazda protiv autoriteta — oni što mrze svako podizanje zaštitnih ograda i uvođenje pravila. Ono što Hartzog i Silbey zapravo definišu jeste ključna građanska uloga koju institucije moraju imati da bi funkcionisale, kao i način na koji te strukture potkopavamo na vlastitu štetu.

Autori vrlo uspješno sjedinjuju ideje, studije i stvarne efekte vještačke inteligencije u niz zanimljivih dokaza. Rad razmatra tri "destruktivne mogućnosti" (afordanse) vještačke inteligencije: potkopavanje ekspertize, prečice u donošenju odluka i izolovanje ljudi. Završni dio rada bavi se sa četiri „institucije kojima će A.I. presuditi: pravom, visokim obrazovanjem, novinarstvom i demokratijom. Lično se osjećam bliže prvom dijelu, onom o destruktivnim afordansama, jer se on poklapa s mojim sopstvenim iskustvom ovog sveprisutnog talasa hajpa koji potapa svaku ozbiljnu raspravu.

Obrazovanje je mjesto na kojem mislim da moramo povući crtu. Ako učimo i živimo moramo računati na greške, neuspjele pokušaje i preuzimanje rizika, pritom ne mislim na opasne rizike nego prosto mogućnosti da budemo u krivu. U protivnom, mijenjamo samu računicu učenja. Rizične ideje i sudari mišljenja od presudne su važnosti.

...AI nije sposobna za intelektualni rizik, odnosno za spremnost da uči, da se upusti u dijalog, da kritikuje i da se izrazi čak i onda kada je ranjiva ili kada može pogriješiti. AI sistemi nisu sposobni za intelektualni rizik jer nemaju istinsku autonomnost, unutrašnju motivaciju, sposobnost da iskuse posljedice. Vještačka inteligencije ne umije izabrati prkos važećim normama, a neće se upustiti u nepoznato, pa makar razlog bila (r)evolucija, otpor ili avantura.

I to treba da nas vodi? Superinteligentni geniji spremni da im otvorimo vaskoliko učenje, društveni život i kulturni izraz? AI nema vlastitu kožu koju bi u ovoj igri stavila kao ulog.

Zviždači unutar institucija, sa druge strane, stavljaju na kocku sopstvenu egzistenciju i ličnu dobrobit, a da ne govorimo o bezbrojnim ljudima koji se suprotstavljaju odlukama svojih nadređenih, iako ih to može koštati posla. AI sistemi nemaju goli interes niti ikakav poriv da dovode u pitanje odluke unutar hijerarhije.

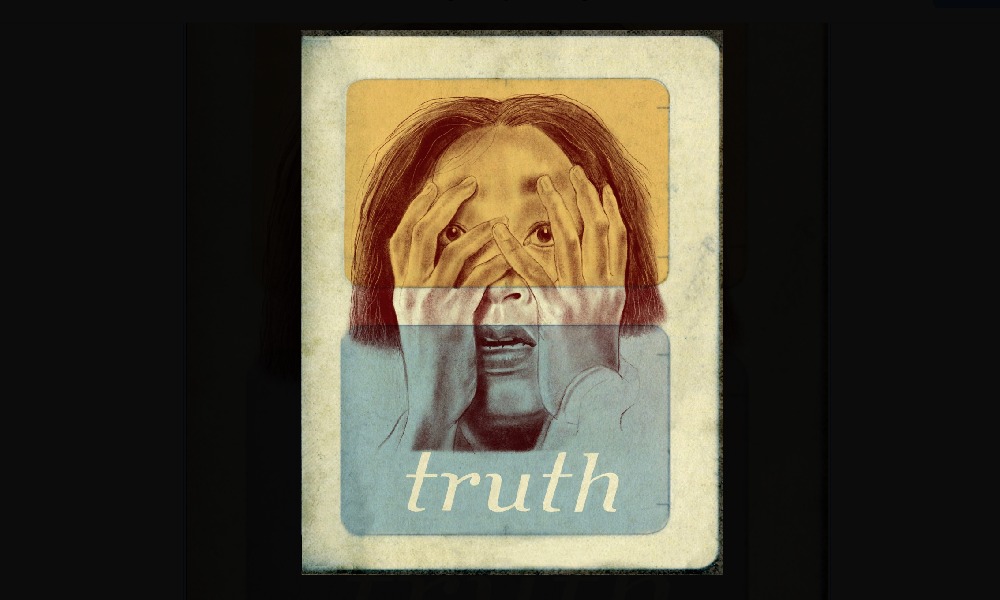

Otud mi više ne kontrolišemo platforme niti aktere koji povlače konce; lutka ne igra za nas — mi smo upleteni u njenu igru. Već sada osjećamo cijenu toga da „vidimo ono u šta vjerujemo“, umjesto da „vjerujemo onome što vidimo“, a AI će dodatno ubrzati to razaranje tkiva povjerenja i istine.

Da, možemo tvrditi da su način na koji primamo „istinu“ kroz istoriju uvijek oblikovale elite i moćnici, ali smo makar mogli da se borimo i težimo nekoj verziji istine. Kako, međutim, da se snađemo u pejzažu koji je proizveden tako da maksimalno zarobljava našu pažnju? Istina i povjerenje postaće sve više plemenski, definisani onim što nas razdvaja; nećemo biti oslobođeni niti ćemo prepoznavati sebe u drugima. Da bismo se izolovali i zaštitili — povući ćemo se.